Le progrès technologique, notamment dans le domaine de l’intelligence artificielle – IA -, a ouvert des perspectives inédites pour la création de contenus visuels. Toutefois, cette avancée est à double tranchant, surtout dans les sociétés où les outils de vérification et la culture numérique ne sont pas encore généralisés, comme c’est le cas en République Démocratique du Congo.

Des extraterrestres travaillant main dans la main avec les Égyptiens pour construire les pyramides, des géants côtoyant les humains, Hitler prenant un selfie avec Donald Trump… Autant d’images réalistes qui sont envoyées sur la toile chaque jour et qui peuvent tromper les plus naïfs par leur réalisme.

Lorsque Midjourney ou DALL-E ont commencé à faire des miracles avec des paysages naturels qui, en y regardant de près, pouvaient ressembler à des êtres humains, ou avec l’image du pape François en doudoune, tout a commencé là.

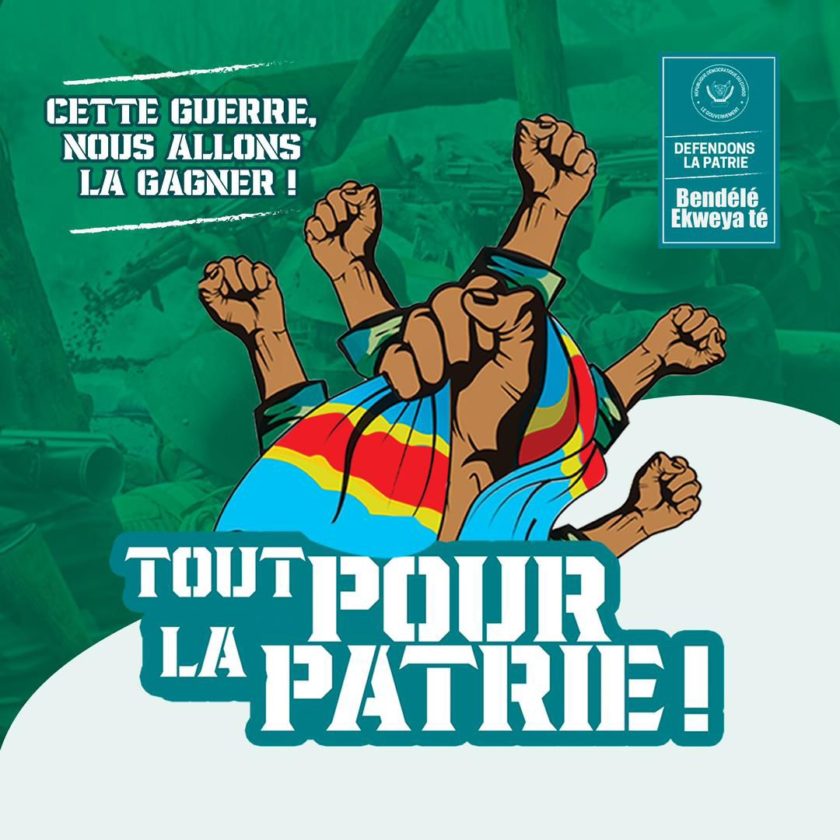

Si certains pouvaient deviner que c’étaient des fausses images, dans nos sociétés, les plus naïfs étaient persuadés que ces images étaient vraies. Mais le danger est encore plus grand puisque ces outils, autrefois inaccessibles, se démocratisent et deviennent accessibles à tous. Désormais, tout le monde peut générer une fausse image quand cela lui chante. Avec Grok2 lancé par X d’Elon Musk récemment, le réalisme des images est stupéfiant et ce service est gratuit, sans restrictions sur les questions politiques sensibles.

Malgré quelques règles qui incluent « ne pas inclure de nudité », « ne pas diffuser de discours haineux, de menaces ou d’attaques directes contre un individu ou un groupe », nombreux sont ceux qui parviennent à concevoir des photos appuyant de possibles fausses informations ou qui nuisent à la crédibilité de personnalités connues.

Le réseau est bombardé d’images réalistes mais fausses qui, entre les mains d’une personne moins apte à juger, peuvent altérer son jugement. Dans nos sociétés où les générations avancées n’ont pas une bonne maîtrise d’internet, il est facile de se laisser berner.

Les images générées par l’IA présentent des dangers potentiels importants pour les sociétés africaines, notamment :

Désinformation et manipulation de l’opinion publique; propagation de fausses informations; atteinte à la réputation et à la vie privée; érosion de la confiance dans les médias et les institutions.

Une aubaine pour le discours complotiste : Ce type de production menace d’alimenter les croyances conspirationnistes. Un internaute a ainsi généré une série de fausses archives montrant, derrière un impeccable jaune sépia, « les Noirs de l’Égypte antique en contact avec des extraterrestres ». C’est une aubaine pour les « chercheurs de vérité » en manque de preuves visuelles et souvent peu regardants sur leur provenance.

Quelques clés pour détecter une image générée par IA : Les solutions réelles face aux dérives des contenus IA

Face aux failles du tatouage numérique, il devient essentiel d’envisager des solutions plus globales. La priorité devrait être l’éducation aux médias afin que les utilisateurs puissent reconnaître et remettre en question ce qu’ils voient. Il est aussi crucial de respecter les droits de propriété intellectuelle. Une meilleure traçabilité de l’origine des images — qu’elles soient générées par IA ou non — pourrait permettre de garantir leur authenticité.

Il est également important de questionner le contexte : normalement, le Président des États-Unis ne peut pas se retrouver dans un bidonville africain ; donc si vous voyez cette image, sachez qu’il s’agit probablement d’une image générée. D’abord, il faut bien évidemment s’interroger sur la source de l’information : d’où vient l’image que l’on a sous les yeux ? A-t-elle été partagée par plusieurs médias ? A-t-elle été authentifiée ? Si ce n’est pas le cas, peut-on raisonnablement admettre qu’elle est crédible avant même d’examiner les détails et imperfections ? Par exemple, on peut douter de l’authenticité d’une photographie montrant Emmanuel Macron au milieu de manifestants ou assis sur un tas d’ordures…

Les mesures à prendre pour limiter ces risques sont :

- Sensibilisation du public : Il est essentiel d’informer le public sur les risques liés à l’utilisation des images générées par l’IA et de leur apprendre à les identifier.

- Réglementation : La mise en place de réglementations strictes est nécessaire pour encadrer l’utilisation de l’IA et lutter contre la désinformation.

- Développement d’outils de détection : Il est important de développer des outils capables de détecter les images générées par l’IA et de les distinguer des images réelles.

- Éducation aux médias : Renforcer l’éducation aux médias est nécessaire pour permettre aux citoyens de développer un esprit critique et ne pas se laisser manipuler par les fausses informations.

- Collaboration internationale : La lutte contre les dangers posés par l’IA nécessite une collaboration internationale pour établir des normes et réglementations communes.

Toutefois, on peut raisonnablement penser que ces logiciels seront encore améliorés et qu’il sera donc toujours plus difficile de repérer ce genre d’anomalies. Plus que jamais, il est donc indispensable de vérifier les informations qui nous parviennent et de conserver un esprit critique en toutes circonstances.

Avoir des arguments pour expliquer à nos proches qui pourraient être tentés de mal interpréter certaines images est essentiel.

PLAMEDI MASAMBA